套利平台Lenard Esau Baum的Baum-Welch(鲍姆-韦尔奇算法模型)

在电气工程、计算机科学、统计计算和生物信息学中,鲍姆-韦尔奇算法是用于寻找隐马尔可夫模型未知参数的最大期望算法,它利用前向-后向算法来计算E-Step的统计信息。

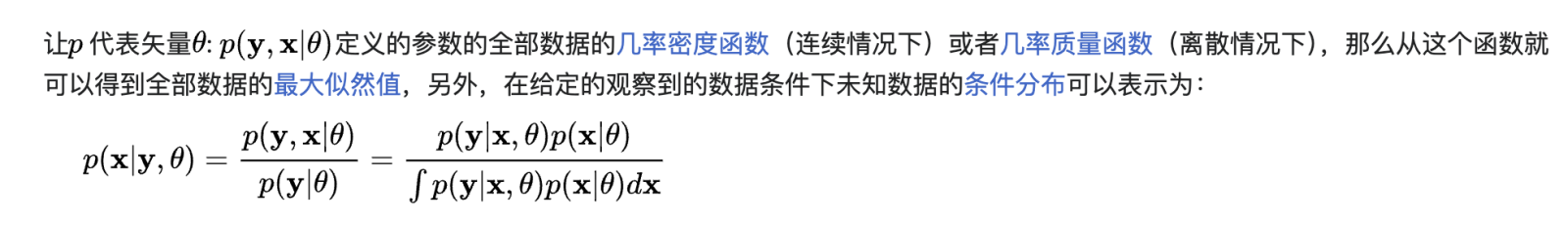

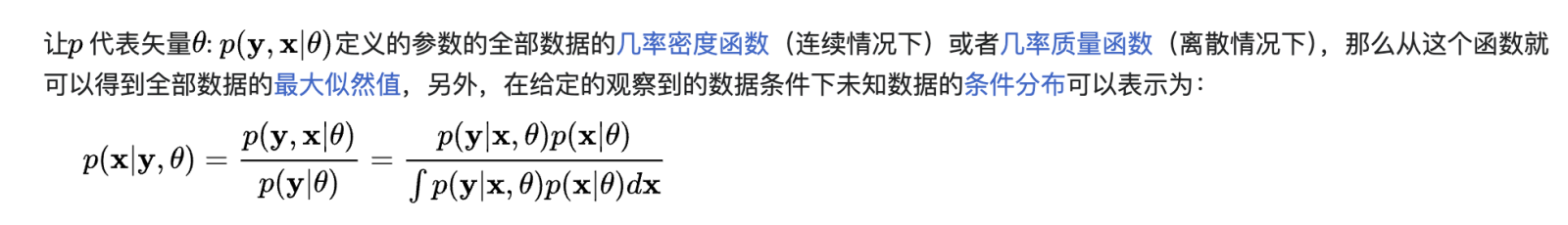

最大期望算法(Expectation-maximization algorithm,又译期望最大化算法)在统计中被用于寻找,依赖于不可观察的隐性变量的概率模型中,参数的最大似然估计。

在统计计算中,最大期望(EM)算法是在概率模型中寻找参数最大似然估计或者最大后验估计的算法,其中概率模型依赖于无法观测的隐变量。最大期望算法经常用在机器学习和计算机视觉的数据聚类(Data Clustering)领域。最大期望算法经过两个步骤交替进行计算,第一步是计算期望(E),利用对隐藏变量的现有估计值,计算其最大似然估计值;第二步是最大化(M),最大化在E步上求得的最大似然值来计算参数的值。M步上找到的参数估计值被用于下一个E步计算中,这个过程不断交替进行。

最大期望值算法由亚瑟·P·丹普斯特,南·莱尔德和唐纳德·鲁宾在他们1977年发表的经典论文中提出。他们指出此方法之前其实已经被很多作者“在他们特定的研究领域中多次提出过”。

EM算法用于在方程不能直接求解的情况下寻找统计模型的(局部)最大似然参数。这些模型中较为典型的是含有潜变量,未知参数并且已知观测数据的模型。也就是说,要么数据中存在缺失的值,要么模型可以通过假设存在更多未观测到的数据点来更简单地表示。以混合模型(Mixture Model)为例,通过假设每个观察到的数据点都有一个对应的未观察到的数据点,也可以说是潜在变量,来指定每个数据点所属的混合部分,这样就可以更简单地描述混合模型。

估计无法观测的数据

鲍姆-韦尔奇算法是以其发明者伦纳德·埃绍·鲍姆和劳埃德·理查德·韦尔奇的名字命名的。鲍姆-韦尔奇算法和隐马尔可夫模型在20世纪60年代末和70年代初由鲍姆和他的同事在国防分析研究所的一系列文章中首次描述。HMMs最初主要应用于语音处理领域。20世纪80年代,HMMs开始成为分析生物系统和信息,特别是遗传信息的有用工具。此后,它们成为基因组序列概率建模的重要工具。

前向过程:

后向过程:

更新:

假设我们有一只会下蛋的鸡,每天中午我们都会去拾取鸡蛋。而鸡是否下蛋依赖于一些未知的隐含状态,这里我们简单的假设只有两种隐含状态会决定它是否下蛋。我们不知道这些隐含状态的初始值,不知道他们之间的转换概率,也不知道在每种状态下鸡会下蛋的概率。我们随机初始化他们来开始猜测。

假设我们得到的观测序列是(E=eggs, N=no eggs): N, N, N, N, N, E, E, N, N, N。

这样我们同时也得到了观测状态的转移:NN, NN, NN, NN, NE, EE, EN, NN, NN。

通过上面的信息来重新估计状态转移矩阵。

为了估计初始状态的概率,我们分别假设序列的开始状态是S1和S2,然后求出最大的概率,再归一化之后更新初始状态的概率。一直重复上面的步骤,直到收敛。

免责声明:社区由Moomoo Technologies Inc.提供,仅用于教育目的。

更多信息

评论

登录发表评论