全球最强的ai芯片要来了!NVIDIA的H200性能提升了90%

跟随我保持信息畅通和互联!

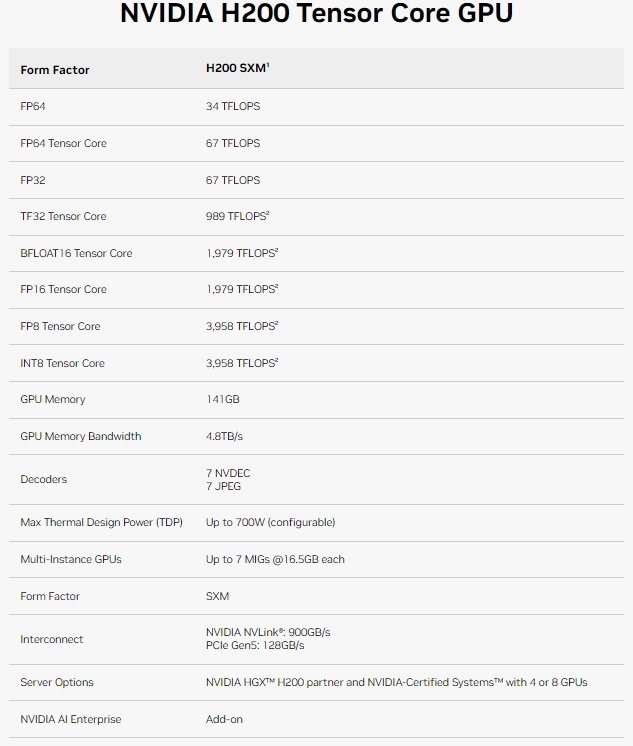

英伟达在周一宣布了使用Hopper架构加速AI应用的HGX H200 Tensor Core GPU。 这是去年发布的H100 GPU的后续产品,也是以前英伟达最强大的AI GPU芯片。如果广泛部署,它可以带来更强大的AI模型,并为现有模型(如ChatGPT)提供更快的响应时间。

英伟达将以几种形式提供H200。包括四路和八路配置的Nvidia HGX H200服务器板,与HGX H100系统的硬件和软件兼容。它还将在Nvidia GH200 Grace Hopper Superchip中提供,这是将CPU和GPU合并到一个封装中,以提供更强大的AI性能的技术术语。

亚马逊网络服务、谷歌云、微软Azure和甲骨文云基础设施将成为首批于明年部署基于H200的云服务提供商。英伟达表示,H200将于2024年第二季度起“全球系统制造商和云服务提供商”上市。

性能提升了1.4-1.9倍

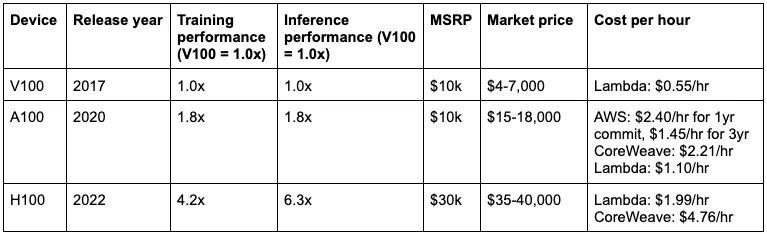

AI进展过去一年面临的主要瓶颈之一是计算能力不足,这妨碍了现有AI模型的部署,并减缓了新模型的开发。主要归咎于加速AI模型的强大GPU的短缺。 缓解计算瓶颈的一种方法是生产更多芯片,但也可以使ai芯片更加强大。第二种方法可能会使H200成为云服务提供商引人注目的产品。

让我们更仔细地看看H200相对H100的性能提升体现在哪里。

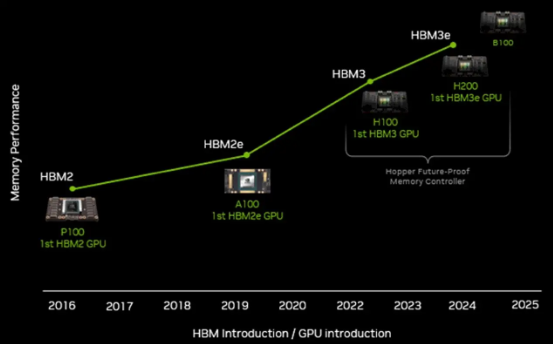

根据NVIDIA公司的说法, H200是该公司首个使用HBM3e内存的芯片。 这种类型的内存速度更快,容量更大,更适合大型语言模型。 下图显示了H100和H200在一系列AI推理工作负载上的相对性能比较:

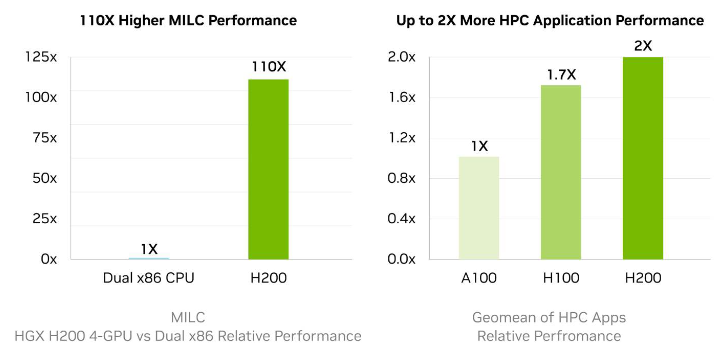

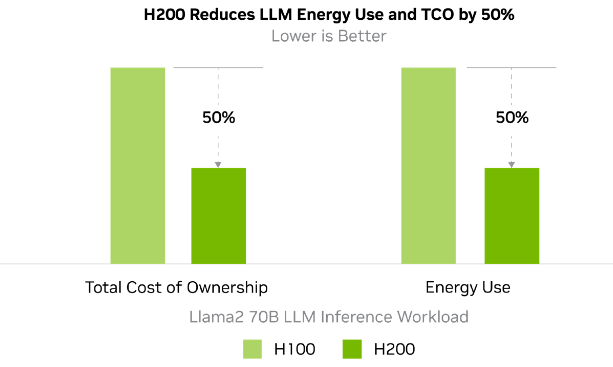

正如所见,与H100相比,H200性能的主要改进在于其在大型模型上的推理性能。 与H100 GPU相比,H200 在处理大型语言模型(如 Llama2 700亿)时的推断性能提高了一倍。

很明显,在相同功耗范围内实现2倍性能提升意味着实际功耗和总体拥有成本降低了50%。 因此,理论上,NVIDIA 可以将 H200 GPU 价格定为与 H100 相似。

随着 H200 的问世,能源效率和总拥有成本达到了新的水平。这种先进的技术在与 H100 Tensor Core GPU 相同的功耗条件下提供了卓越的性能。 不仅更快,而且更环保的人工智能工厂和超级计算系统为推动人工智能和科学界提供了经济优势。

在 Transformer 引擎、降低的浮点精度和更快的 HBM3 存储器的帮助下,自今年起已经全面交付的 H100 在 GPt-3 1750亿模型上的推断性能已经增加了11倍,与 A100 相比。借助更大更快的 HBM3e 存储器,H200 可以直接将性能提升多达 18 倍,无需进行任何硬件或代码更改。 与 H100 相比,H200 的性能增加了1.64倍,纯粹是由于内存容量和带宽的增长。

为了防止库存大量 H100 GPU 的客户感到不满,NVIDIA 似乎只有一种解决方案: 将配备141 Gb HBM3e内存的霍珀定价为80 Gb或96 Gb HBM3内存版本的1.5到2倍价格。 想象一下,如果未来设备配备512 Gb的HBm内存和10 TB/s带宽,将会达到什么级别的性能?您愿意为这款功能齐全的GPU支付多少? 最终产品可能售价6万美元甚至9万美元,因为许多用户已经愿意为目前尚未完全利用的产品支付3万美元。

更多内存

出于各种技术和经济原因,处理器在几十年来往往配置了过多的计算能力,但相应的内存带宽相对不足。实际的内存容量通常取决于设备和工作负载的要求。在HPC模拟/建模甚至AI训练/推断领域,即使是最先进的GPU的内存带宽和内存容量相对不足,无法实质性提高现有芯片上的矢量和矩阵引擎的利用率。 因此,这些GPU只能花费大量时间等待数据传递,无法充分利用它们的优势。

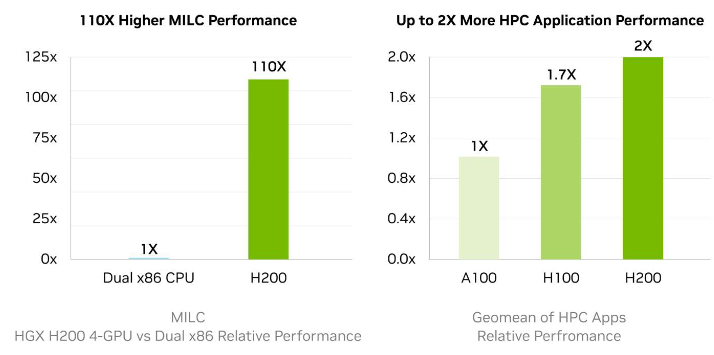

内存带宽对HPC应用至关重要,因为它可以实现更快的数据传输,减少复杂处理的瓶颈。 对于像模拟、科学研究和人工智能等内存密集型HPC应用,H200更高的内存带宽确保数据可以被高效地访问和操作,从而使结果时间快110倍。

B100即将推出

大约一个月前,在英伟达的财务会议上,该公司发布了其科技路线图。 公布了GH200 GPU和H200 GPU加速器将作为过渡产品,之后将推出"Blackwell" GB100 GPU和B100 GPU,计划于2024年发布。

不论英伟达的Blackwell B100 GPU加速器的性能如何,可以假定它将带来更强大的推理性能,而这种性能提升可能来自于内存方面的突破,而不是计算级别的升级。这里看一下B100 GPU在GPt-3 1750亿参数模型上的推理性能改进:

最终,尽管Blackwell B100加速器将于明年三月的GTC 2024大会上首次亮相,但实际出货预计要等到2024年底。

当评估芯片行业的竞争格局时,显而易见英伟达面临几个竞争对手和潜在威胁:

AMD:AMD是一家资金雄厚、拥有强大GPU专业知识的芯片制造商。 然而,它在软件方面相对薄弱可能会影响其与英伟达有效竞争的能力。

英特尔:尽管英特尔在AI加速器或GPU上并不十分成功,但不应被低估。 作为半导体行业的重要参与者,英特尔拥有资源和能力在该领域取得重大进展。

超大规模云计算供应商的自研解决方案:谷歌、亚马逊、微软和Meta平台等公司正在开发自己的内部芯片,如TPU、Trainium和Inferentia。 尽管这些芯片在特定工作负载中可能表现出色,但在广泛应用范围内可能无法超越英伟达的GPU。

云计算服务商: 云服务提供商需要提供各种GPU和加速器来满足企业客户运行AI工作负载的需求。 虽然亚马逊和谷歌可能会将其自研芯片用于自己的AI模型,但说服广泛的企业客户为这些专有半导体优化其AI模型可能导致供应商锁定,而企业通常会避免这种情况。

在竞争激烈的AI芯片市场上,正如市场对英伟达的领先地位产生质疑,这样一款芯片的发布无疑给英伟达的投资者带来了很多信心。 基于持续的产品创新,英伟达在行业中仍然保持着显著的领先优势。然而,最大的不确定性在于中国。英伟达为其中国市场定制了H20芯片,以绕过政府监管。 在下一篇文章中,我将比较英伟达的中国版芯片是否能满足需求。

免责声明:社区由Moomoo Technologies Inc.提供,仅用于教育目的。

更多信息

评论

登录发表评论

calm Flamingo_6328 : 你看起来根本不像一个泰国人