分析认为,Llama 3 405B不仅仅是人工智能能力的又一次提升,对于开源 AI 来说,“这是一个潜在的 ChatGPT 时刻”。在基准测试中,Meta Llama 3.1 在GSM8K、Hellaswag等多项测试中均优于 GPT-4o。

千呼万唤始出来,原定于23日发布的Llama 3 405B就要来了。

作为Llama 3系列中的顶配,405B版本拥有4050亿个参数,是迄今为止最大的开源模型之一。

昨夜凌晨,META突发Llama 3.1-405B评测数据的泄漏事件,有网友预计可能还会同时发布一个Llama 3.1-70B版本,因为“(模型提前泄露)是META的老传统了,去年的Llama模型就干过一次。”

昨夜凌晨,META突发Llama 3.1-405B评测数据的泄漏事件,有网友预计可能还会同时发布一个Llama 3.1-70B版本,因为“(模型提前泄露)是META的老传统了,去年的Llama模型就干过一次。”

有分析认为,Llama 3 405B不仅仅是人工智能能力的又一次提升,对于开源AI 来说,“这是一个潜在的ChatGPT时刻”,其中最先进的人工智能真正实现民主化并直接交到开发人员手中。

对即将到来的 Llama 3 405B 公告的三个预测

有分析人士从数据质量、模型生态系统、API解决方案三个角度,预测了即将到来的Llama 3 405B公告中的亮点。

首先,Llama 3 405B或许会彻底改变专用模型的数据质量。

对于专注于构建专业AI模型的开发人员来说,他们面临的长期挑战是获取高质量的训练数据。较小的专家模型(1-10B 个参数)通常利用蒸馏技术,利用较大模型的输出来增强其训练数据集。然而,使用来自OpenAI等闭源巨头的此类数据受到严格限制,限制了商业应用。

Llama 3 405B应运而生。作为一款与专有模型实力相媲美的开源巨头,它为开发人员创建丰富、不受限制的数据集提供了新的基础。这意味着开发人员可以自由使用Llama 3 405B的蒸馏输出来训练小众模型,从而大大加快专业领域的创新和部署周期。预计高性能、经过微调的模型的开发将激增,这些模型既强大又符合开源道德规范。

其次,Llama 3 405B将形成新的模型生态系统:从基础模型到专家组合

Llama 3 405B的推出可能会重新定义AI系统的架构。该模型的庞大规模(4050 亿个参数)可能意味着一种一刀切的解决方案,但真正的力量在于它与分层模型系统的集成。这种方法对于使用不同规模AI的开发人员来说尤其具有共鸣。

预计会转向更具动态的模型生态系统,其中Llama 3 405B充当骨干,由小型和中型模型提供支持。这些系统可能会采用推测解码等技术,其中不太复杂的模型处理大部分处理,仅在必要时调用405B模型进行验证和纠错。这不仅可以最大限度地提高效率,而且还为优化实时应用程序中的计算资源和响应时间开辟了新途径,尤其是在针对这些任务优化的SambaNova RDU上运行时。

最后,Llama 3 405B有最高效 API 的竞争

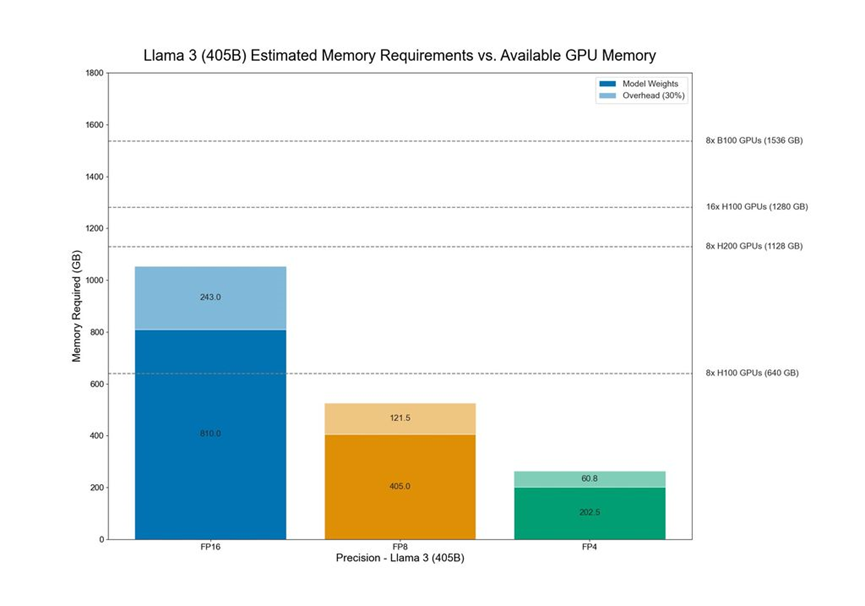

能力越大,责任越大——对于Llama 3 405B而言,部署是一项重大挑战。开发人员和组织需要谨慎应对模型的复杂性和运营需求。AI云提供商之间将展开竞争,以提供部署Llama 3 405B最高效、最具成本效益的API解决方案。

这种情况为开发人员提供了一个独特的机会,可以与不同的平台互动,比较各种API如何处理如此庞大的模型。这个领域的赢家将是那些能够提供API的人,这些API不仅可以有效地管理计算负载,而且不会牺牲模型的准确性或不成比例地增加碳足迹。

总之,Llama 3 405B不仅仅是AI武器库中的又一个工具;更是向着开放、可扩展和高效的 AI 开发的根本转变。分析认为,无论是在微调小众模型、构建复杂的AI系统还是优化部署策略,Llama 3 405B的到来都将为用户打开新的视野。

网友们怎么看?

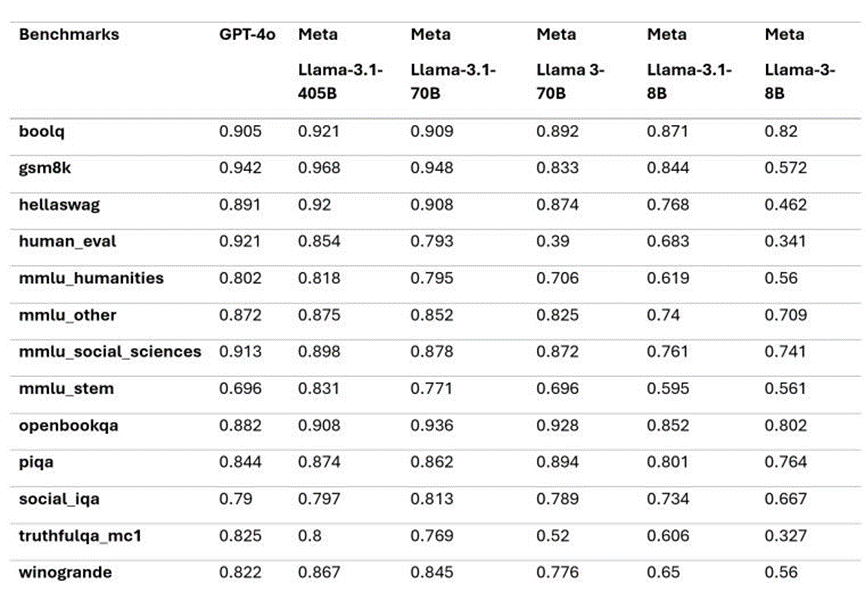

网友在LocalLLaMA子Reddit板块中发帖,分享了4050亿参数的Meta Llama 3.1信息,从该AI模型在几个关键AI基准测试的结果来看,其性能超越目前的领先者,即OpenAI的GPT-4o,这标志着开源模型可能首次击败目前最先进的闭源LLM模型。

如基准测试所示,Meta Llama 3.1在 GSM8K、Hellaswag、boolq、MMLU-humanities、MMLU-other、MMLU-stem和 winograd等多项测试中均优于 GPT-4o,但是,它在 HumanEval和 MMLU-social sciences方面却落后于 GPT-4o。

宾夕法尼亚大学沃顿商学院副教授伊桑·莫利克(Ethan Mollick)写道:

如果这些统计数据属实,那么可以说顶级 Al 模型将在本周开始免费向所有人开放。

全球每个国家的政府、组织和公司都可以像其他人一样使用相同的人工智能功能。这会很有趣。

有网友总结了Llama 3.1模型的几个亮点:

模型使用了公开来源的15T+tokens进行训练,预训练数据截止日期为2023年12月;

微调数据包括公开可用的指令微调数据集(与Llama 3不同)和1500万个合成样本;

模型支持多语言,包括英语、法语、德语、印地语、意大利语、葡萄牙语、西班牙语和泰语。

有网友表示,这是首次开源模型超越了GPT4o和Claude Sonnet 3.5等闭源模型,在多个benchmark上达到SOTA。