理光公司(社长执行役员:大山 晃)基于美国Meta Platforms公司提供的「Meta-Llama-3-70B」,改进了其日本性能,推出了基于「Llama-3-Swallow-70B*1」的基础型号,通过合并公司的Instruct模型中的Chat Vector*2和理光制造的Chat Vector*3,结合理光独有的技术,开发了高性能的日本大型语言模型(LLM*4)。这样一来,理光开发和提供的LLM系列中增加了与美国OpenAI开发的GPT-4相当的高性能模型。

随着生成AI的普及,企业对可用于业务的高性能LLM的需求日益增加。然而,LLM的追加学习存在高成本和时间耗费的挑战。针对这一问题,将多个模型结合以创建更高性能模型的"模型融合*5"技术备受关注,被视为一种高效的开发方法。

理光公司基于模型融合的技术与LLM开发的经验,开发了新的LLM。这项技术有助于提高企业内部私有LLM以及特定业务用途的高性能LLM的开发效率。

除了开发公司自家的LLM外,为了在客户的用例和环境下提供最适合的LLM且成本低、交付快,理光将推动各种多样且高效的方法和技术的研究与开发。

除了开发公司自家的LLM外,为了在客户的用例和环境下提供最适合的LLM且成本低、交付快,理光将推动各种多样且高效的方法和技术的研究与开发。

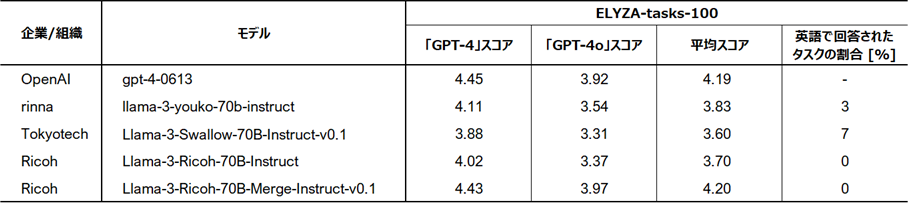

评估结果*6(ELYZA-tasks-100)

在包含复杂指示和任务的代表性日本语基准测试「ELYZA-tasks-100」中,理光通过模型融合方法开发的LLM展示出与GPT-4相当水平的高分。此外,与其他LLM相比,它展现出针对所有任务都用日语回答且表现出高度稳定性,而其他模型在某些任务中以英语回答。

基准工具(ELYZA-tasks-100)中与其他模型的比较结果(理光位于最下方)

基准工具(ELYZA-tasks-100)中与其他模型的比较结果(理光位于最下方)Ricoh的LLM开发背景

在劳动力减少和人口老龄化的背景下,提高生产力和提供高附加值的工作方式成为企业增长的难题,为解决此问题,许多企业开始注意使用AI进行业务活用。然而,要将AI应用到实际的应用中,就需要将包含企业专有术语和语句的大量文本数据学习到LLM中,并创建企业独有的AI模型(专用LLM)。

以国内顶尖的LLM开发/学习技术为基础,Ricoh可以提供企业专用LLM的服务,以及推广使用内部文档的RAG等各种AI解决方案的建议。

相关股票新闻

- 理光开发了7千亿参数的大规模语言模型(LLM),支持日语、英语和中文,加强了客户的私有LLM构建支持。

- 开发了已经调整好指令的日语LLM,其参数为130亿

- 开发了具有高日语精度的130亿参数的大规模语言模型(LLM)

您可以在PDF文件中查看此新闻稿

理光通过模型融合开发了等同于GPT-4的高性能日语LLM(700亿参数),总共224KB,分为2页。

リコーは、自社製LLMの開発だけではなく、お客様の用途や環境に合わせて、最適なLLMを低コスト・短納期でご提供するために、多様で効率的な手法・技術の研究開発を推進してまいります。

リコーは、自社製LLMの開発だけではなく、お客様の用途や環境に合わせて、最適なLLMを低コスト・短納期でご提供するために、多様で効率的な手法・技術の研究開発を推進してまいります。