ninja turtle

評論了

ninja turtle

參與了投票

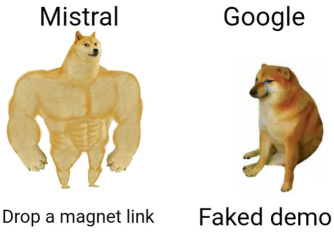

開源奇蹟再次展開:Mistral AI發布了第一個開源的專家混合模型(MoE)大型模型。

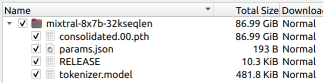

僅幾天前,一個磁力鏈接瞬間在人工智能社區引起了轟動。

一個87Gb的seed,一個8x70億MoE架構 - 它看起來像是“Open-Source GPt-4”的迷你版本!

沒有新聞發布會,沒有宣傳視頻 - 只是一個磁力鏈接...

僅幾天前,一個磁力鏈接瞬間在人工智能社區引起了轟動。

一個87Gb的seed,一個8x70億MoE架構 - 它看起來像是“Open-Source GPt-4”的迷你版本!

沒有新聞發布會,沒有宣傳視頻 - 只是一個磁力鏈接...

已翻譯

5

1

ninja turtle

讚並評論了

2

2

![[empty]](https://static.moomoo.com/node_futunn_nnq/assets/images/folder.5c37692712.png)

![[error]](https://static.moomoo.com/node_futunn_nnq/assets/images/no-network.991ae8055c.png)

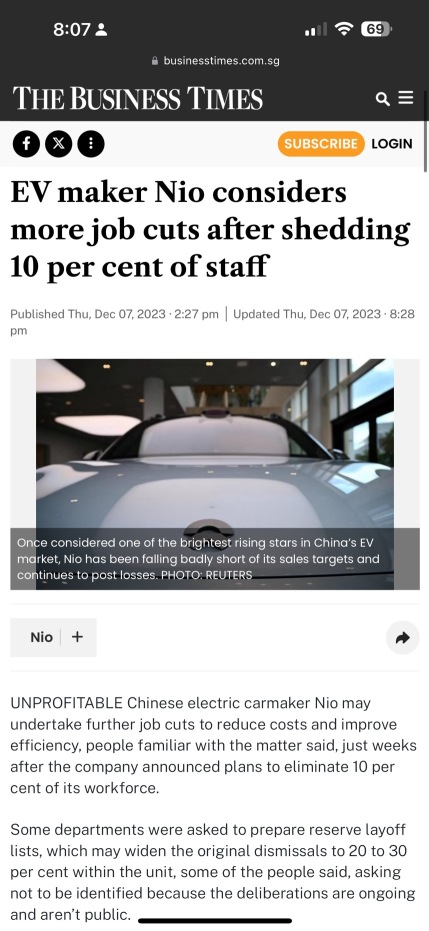

ninja turtle 70952329 : 卧槽,你买了20万股这个垃圾?