速度是把雙刃劍

火爆AI圈,刷屏互聯網!

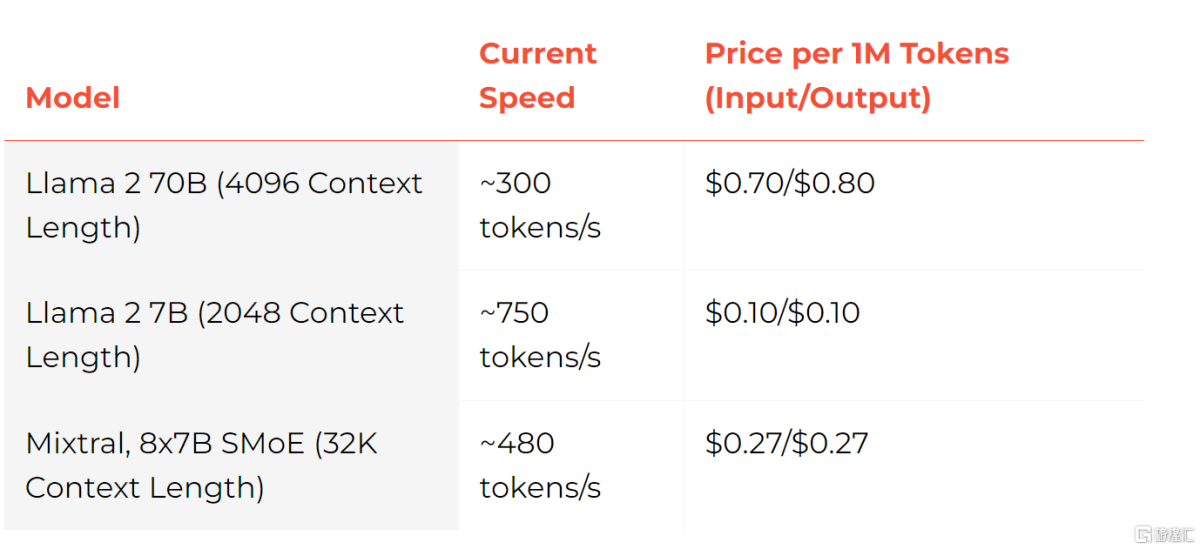

近期,Groq引發廣泛討論,其大模型每秒能輸出750個tokens,比GPT-3.5快18倍,自研LPU推理速度是英偉達GPU的10倍。

速度快得出奇

Groq名字與馬斯克的大模型Grok讀音類似,成立於2016年,定位爲一家人工智能解決方案公司。

Groq爆火主要是因爲其處理速度非常快。據媒體報道,該公司的芯片推理速度較英偉達GPU提高10倍,成本只有其1/10。

運行的大模型生成速度接近每秒500 tokens,碾壓ChatGPT-3.5大約40 tokens/秒的速度。

極限情況下,Groq的Llama2 7B甚至能實現每秒750 tokens,爲GPT-3.5的18倍。

在Groq的創始團隊中,有8人來自谷歌早期TPU核心設計團隊,但Groq並未選擇TPU、GPU、CPU等路線,而是自研了語言處理單元(LPU)。

Groq官網顯示,在 Groq LPU推理引擎上運行的Meta AI的Llama 2 70B的性能優於所有其他基於雲的推理提供商,吞吐量提高了18倍。

能否取代英偉達?

不過,速度並不是AI發展的唯一決定性因素。在Groq爆火的同時,也有一些質疑聲音。

首先,Groq似乎只是看起來了便宜。Groq的一張LPU卡僅有230MB的內存,售價爲2萬多美元。

有網友分析,英偉達H100的成本效益應爲Groq的11倍。

更爲關鍵的是,Groq LPU完全不配備高帶寬存儲器(HBM),而是僅配備了一小塊的超高速靜態隨機存取存儲器(SRAM),這種SRAM的速度比HBM3快20倍。

這也意味着,與英偉達的H200相比,在運行單個AI模型時需要配置更多的Groq LPU。

另據Groq員工透露,Groq的LLM在數百個芯片上運行。

對此,騰訊科技的芯片專家姚金鑫認爲,Groq的芯片目前並不能取代英偉達。

他認爲,速度是Groq的雙刃劍。Groq的架構建立在小內存、大算力上,因此有限的被處理的內容對應着極高的算力,導致其速度非常快。

另一方面,Groq極高的速度是建立在很有限的單卡吞吐能力上的,要保證和H100同樣吞吐量,就需要更多的卡。

他分析,對於Groq這種架構來講,也有其盡顯長處的應用場景,對許多需要頻繁數據搬運的場景來說再好不過。