①Cerebras基於其自己的芯片計算系統發佈了號稱世界上速度最快的AI推理服務;②Cerebras將內存直接內置在巨大的芯片中,從而擁有巨大的片上內存和極高的內存帶寬。

《科創板日報》8月28日訊(編輯 朱凌)當地時間週三盤後,英偉達即將公佈整個二級市場的最後一份重磅二季報,全球投資者因此高度緊張。而就在前一天(當地時間8月27日),美國人工智能處理器芯片獨角獸Cerebras Systems基於其自己的芯片計算系統發佈了號稱世界上速度最快的AI推理服務,聲稱比使用英偉達H100 GPU構建的系統快十到二十倍。

目前,英偉達GPU在AI訓練和推理兩方面都佔據着市場主導地位。Cerebras自2019年推出首款AI芯片以來,一直專注銷售AI芯片和計算系統,致力於在AI訓練領域挑戰英偉達。

根據美國科技媒體The Information的報道,得益於AI推理服務,OpenAI今年收入預計將達到34億美元。既然AI推理的蛋糕這麼大,Cerebras聯合創始人兼首席執行官安德魯·費爾德曼表示,Cerebras也要在AI市場上佔據一席之地。

根據美國科技媒體The Information的報道,得益於AI推理服務,OpenAI今年收入預計將達到34億美元。既然AI推理的蛋糕這麼大,Cerebras聯合創始人兼首席執行官安德魯·費爾德曼表示,Cerebras也要在AI市場上佔據一席之地。

Cerebras這次推出AI推理服務不僅開啓了AI芯片和計算系統之外,基於使用量的第二收入曲線,更是發起了對英偉達的全面進攻。「從英偉達手中搶走足夠讓他們生氣了的市場份額。」費爾德曼如是說。

又快又便宜

Cerebras的AI推理服務在速度和成本上均表現出顯著優勢。據費爾德曼介紹,以每秒可輸出的token數量來衡量,Cerebras的AI推理速度是微軟Azure、亞馬遜AWS等雲服務商運行的AI推理服務的20倍。

費爾德曼在發佈會現場同時啓動了Cerebras與亞馬遜AWS的AI推理服務,Cerebras可以瞬間完成推理工作並輸出,處理速度達到每秒1832個tokens,而AWS需要幾秒鐘才能完成輸出,處理速度僅爲每秒93個tokens。

費爾德曼稱,更快的推理速度意味着,可以實現實時交互式語音回答,或通過調用多輪結果、更多外部來源、更長文檔,從而獲得更準確、更相關的回答,給AI推理帶來質的飛躍。

除了速度優勢外,Cerebras還有巨大的成本優勢。費爾德曼表示,Cerebras的AI推理服務性價比是AWS等的100倍。以運行Meta的Llama 3.1 70B開源大型語言模型爲例,該服務的價格爲每個token僅需60美分,而一般雲服務商提供的相同服務每個令牌價格爲2.90美元。

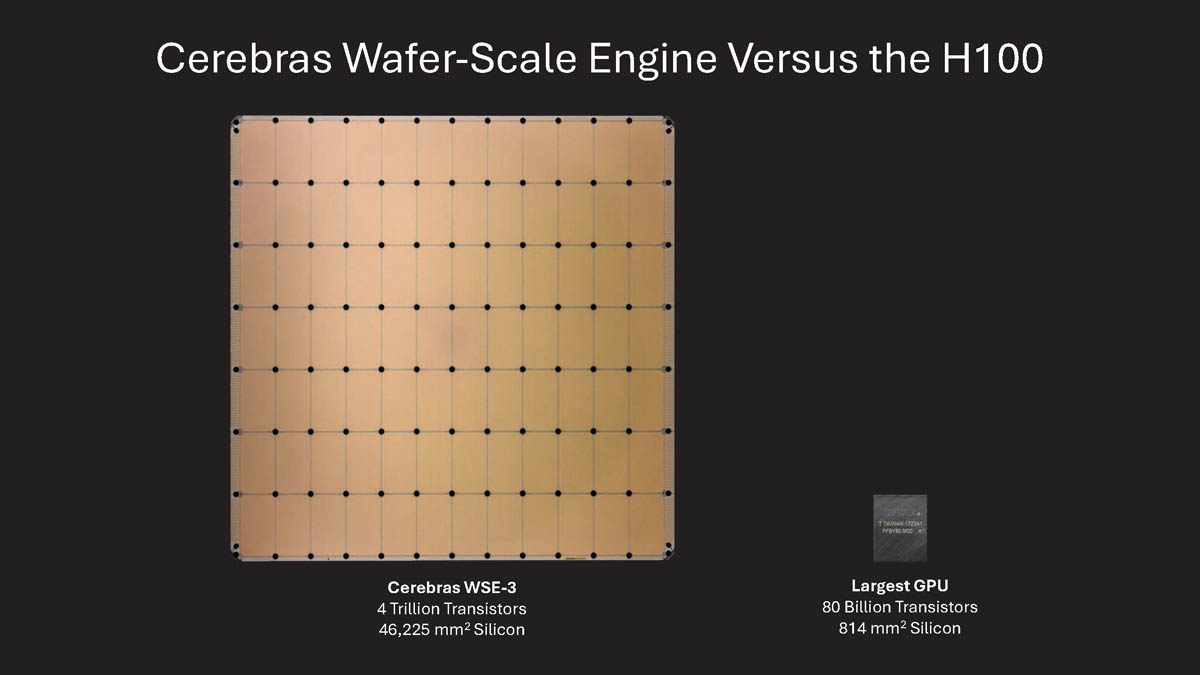

目前最大GPU面積的56倍

Cerebras的AI推理服務又快又便宜的原因在於其WSE-3芯片的設計。這是Cerebras今年3月推出的第三代處理器芯片,它的尺寸巨大,幾乎相當於一個12英寸半導體晶片的整個表面,或者說比一本書還要大,單體面積達到約462.25平方厘米。它是目前最大GPU面積的56倍。

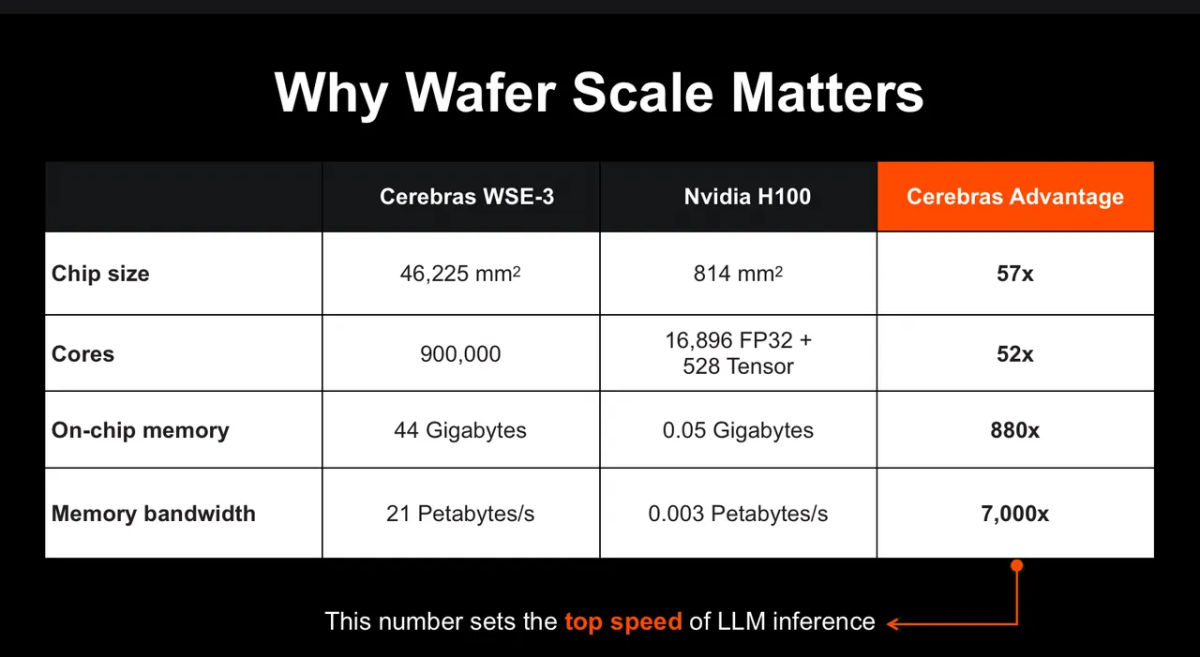

WSE-3芯片沒有像英偉達那樣採用需要通過接口連接才能訪問的獨立高帶寬存儲器(HBM)。相反,它將內存直接內置在芯片中。

得益於芯片尺寸,WSE-3的片上存儲器(On-chip memory)高達44G,幾乎是英偉達H100的900倍,內存帶寬是英偉達H100的7000倍。

費爾德曼表示,內存帶寬是限制語言模型推理性能的根本因素。而Cerebras將邏輯和內存整合到一個巨型芯片中,擁有巨大的片上內存和極高的內存帶寬,可以快速地處理數據併產生推理結果。「這是GPU不可能達到的速度。」

除了速度和成本優勢外,WSE-3芯片還是AI訓練和推理兩面手,在處理各種AI任務時都具有卓越的性能。

根據計劃,Cerebras將在多個地點建立AI推理數據中心,並將按請求次數對推理能力收費。同時,Cerebras還將向嘗試向雲服務商出售基於WSE-3的CS-3計算系統。

根据美国科技媒体The Information的报道,得益于AI推理服务,OpenAI今年收入预计将达到34亿美元。既然AI推理的蛋糕这么大,Cerebras联合创始人兼首席执行官安德鲁·费尔德曼表示,Cerebras也要在AI市场上占据一席之地。

根据美国科技媒体The Information的报道,得益于AI推理服务,OpenAI今年收入预计将达到34亿美元。既然AI推理的蛋糕这么大,Cerebras联合创始人兼首席执行官安德鲁·费尔德曼表示,Cerebras也要在AI市场上占据一席之地。