NVDA

エヌビディア

-- 140.110 RGTI

リジッティ・コンピューティング・インク

-- 10.0400 TSLA

テスラ

-- 394.940 TSM

台湾セミコンダクター・マニュファクチャリング

-- 207.120 AMD

アドバンスト・マイクロ・デバイシズ

-- 121.840

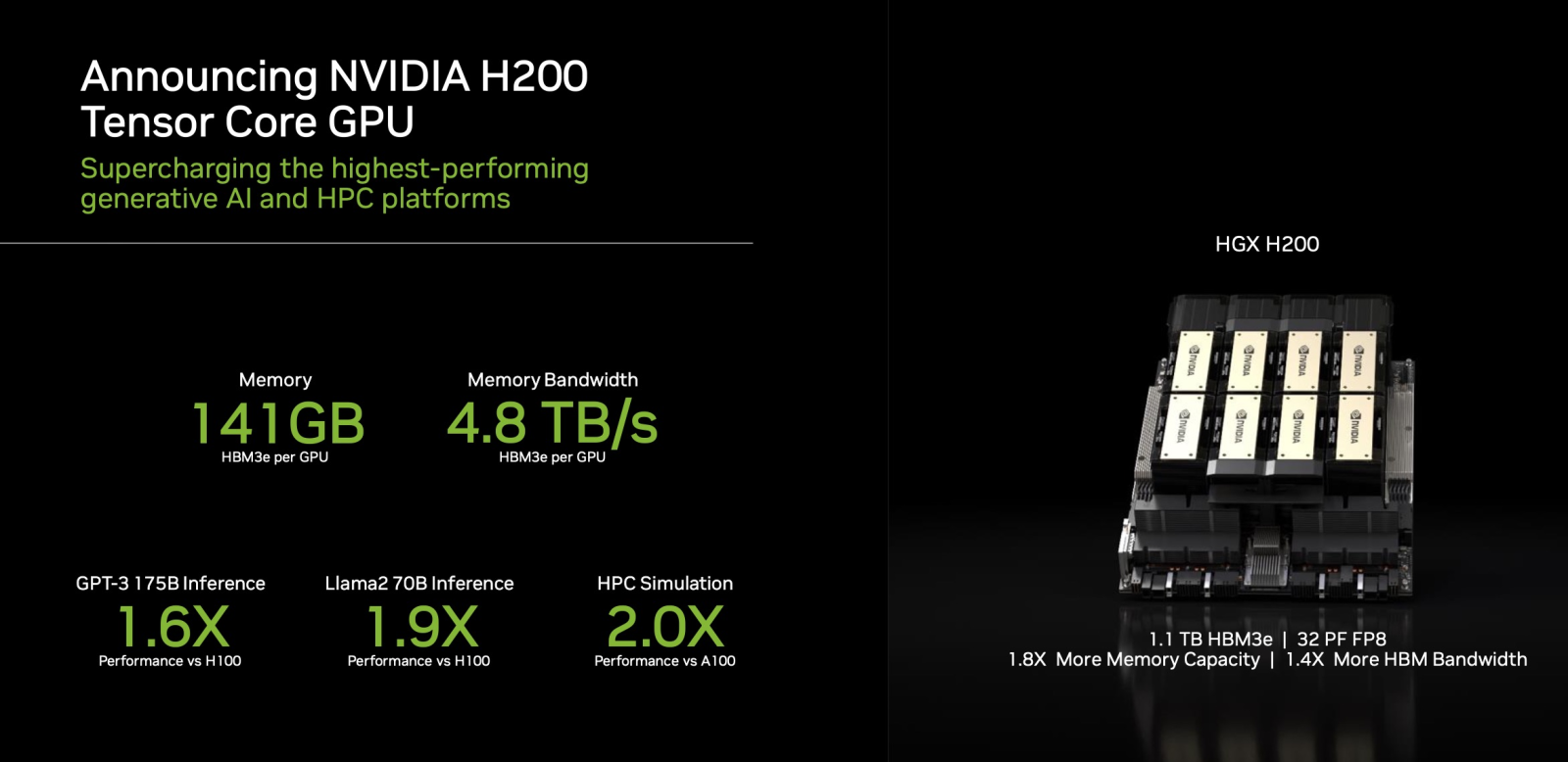

「HBM3eにより、NVIDIA H200は141GBのメモリを4.8テラバイト/秒で実現し、その前身であるNVIDIA A100と比較して、ほぼ2倍の容量と2.4倍のバンド幅を提供します」と、同社は述べている。

スーパーコンピューター向けに設計されており、「科学者や研究者が、テラバイト級のデータを実行する複雑なAIやHPCアプリケーションを高速化することで、世界で最も困難な問題に取り組めるようにする」とエヌビディアは述べている。GH200は、Dell、Eviden、Hewlett Packard Enterprise(HPE)、Lenovo、QCT、Supermicroなど、「世界の研究センター、システムメーカー、クラウドプロバイダーの40以上のAIスーパーコンピューター」で使用される予定だと同社は述べている。

181338057犬心久美子 : いいね 有難う御座います。