近日、外部メディアが新しいNVIDIA GPUのロードマップを公開し、史上最強のB100の技術詳細がすべて明らかになったが、その中で最も神秘的なX100は2025年に発売される予定です。

NVIDIAのAIハードウェアは長すぎます!

今、各大手の技術企業が狙って、その覇者の地位を一気に転覆しようとしています。

当然、NVIDIAも放置しないでしょう。

当然、NVIDIAも放置しないでしょう。

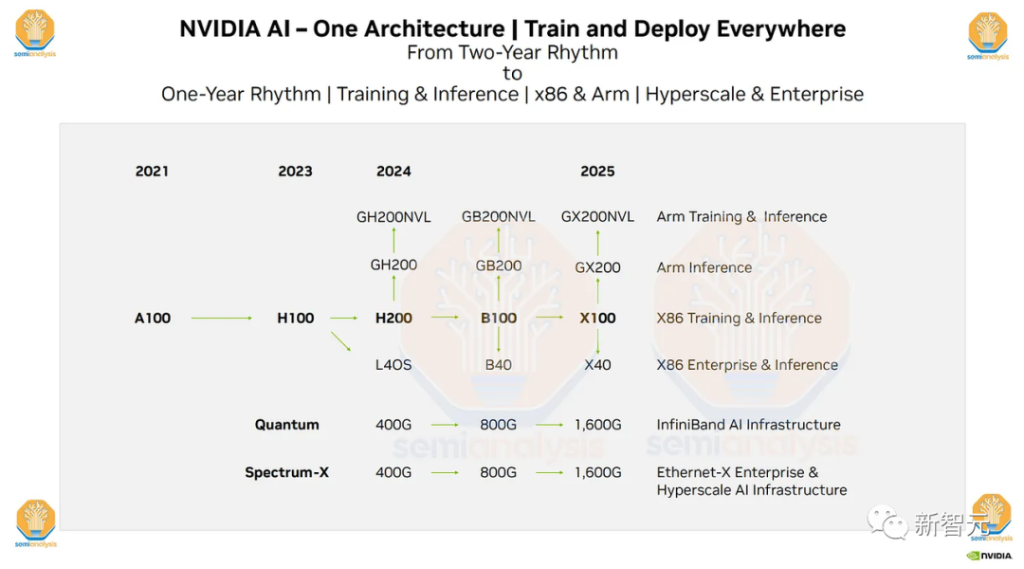

最近、米SemiAnalysisは、NVIDIAの将来数年間のハードウェアロードマップを公開し、注目されているH200、B100、および「X100」GPUを含んでいます。

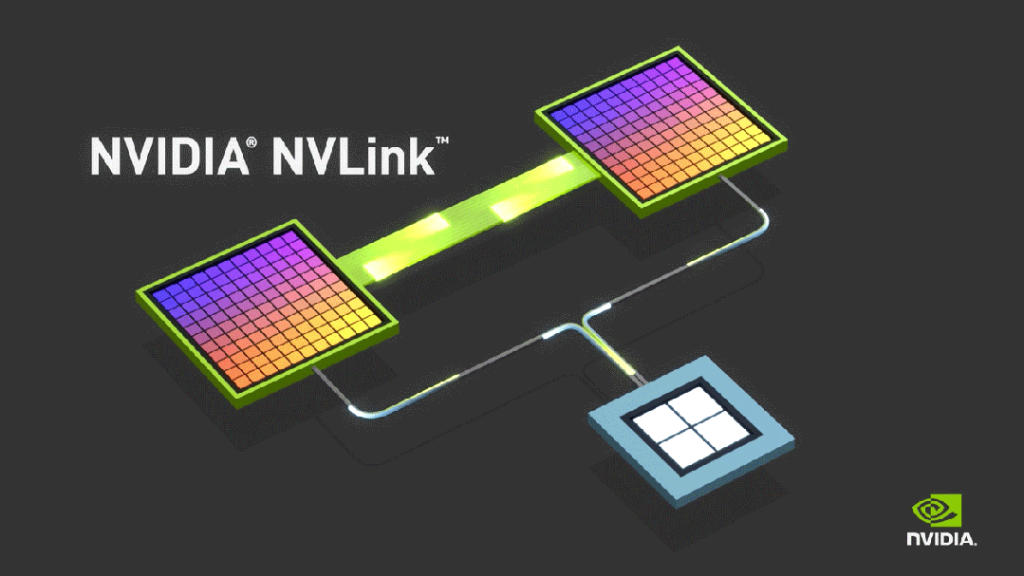

随って一緒に流出した情報の中には、NVIDIAの製造技術計画、HBM3Eの速度/容量、PCIe 6.0、PCIe 7.0、NVLink、1.6T 224G SerDes計画などの硬核情報も含まれています。

これらの計画が成功すれば、NVIDIAは競合他社を圧倒し続けるだろう。

当然、覇者の座は簡単に手に入るものではありません - AMDのMI300、MI400、AmazonのTrainium2、Microsoftのアテナ、IntelのGaudi 3はNVIDIAを苦しめることはないでしょう。

準備してください、前方高エネルギーが襲来します!

NVIDIAは、ハードウェアの覇権を握りたいと考えているわけではありません

Googleは既に自社のAIインフラ基盤の構築を開始しており、彼らが構築したTPUv5とTPUv5eは、内部のトレーニングや推論に利用できるだけでなく、Apple、Anthropic、CharacterAI、MidJourneyなどの外部顧客にも提供可能です。

グーグルはNVIDIAの唯一の脅威ではありません。

ソフトウェアの面では、MetaのPyTorch 2.0やOpenAIのTritonも急速に発展しており、他のハードウェアサプライヤーが互換性を実現できるようにしています。

現在、ソフトウェア上の差異はまだ存在していますが、以前ほど大きくはありません。

ソフトウェアスタックにおいて、AMDのGPU、IntelのGaudi、MetaのMTIA、そしてMicrosoftのAthenaはすべてある程度の発展を遂げています。

英ウィナミンがまだハードウェアで先行しているが、差は縮小していくことになるだろう。

英伟达 H100 も、長く独领し続けることはできないだろう。

今後数ヶ月間、AMDのMI300またはインテルのGaudi 3は、どちらもH100より技術的に優れたハードウェア製品を発売する予定です。

GoogleやAMD、インテルなどの強敵に加えて、いくつかの企業もNVIDIAにかなりのプレッシャーを与えています。

これらの企業はハードウェア設計では一時的に遅れていますが、背後に巨大な企業の支援を得ることができます。NVIDIAは長らく苦労しており、これらの企業はすべてHBMでのNVIDIAの巨額利益独占を打破したいと考えています。

Amazonが近日中に発売するTrainium2とInferentia3、そしてMicrosoftが近日中に発売するAthenaは、ともに数年にわたる投資の成果です。

競合相手の攻勢が激しく、英伟達はもちろん臥して待つことはない。

外国メディアSemiAnalysisによれば、マネジメントスタイルまたは方針決定、NVIDIAは「業界で最も疑念の多い企業の一つ」である。

黄仁勋の人柄には、アンディ・グルーフの精神が表れています。

成功は自己満足を引き起こす。自己満足は失敗を引き起こす。偏執狂のみが生き残ることができる。英ウィッシュの最初の交換席に据えるために、英伟达は野心的で、多くの冒険的な戦略を採用しています。

彼らは、もはや従来の市場でインテルやAMDと競争することを見下しており、Google、マイクロソフト、Amazon、Meta、Appleのようなテクノロジー巨頭になりたいと考えています。

そして、NVIDIAのDGX Cloudやソフトウェア、半導体以外の分野への買収戦略は、すべて大局を考えたものです。

ロードマップの最新の詳細が公開されました!

NVIDIAの最新ロードマップの重要な詳細がすでに明らかにされました。

内容には、採用されているネットワーク、メモリ、パッケージ、プロセスノード、各種GPU、SerDes選択、PCIe6.0、協調パッケージング光学デバイス、光学スイッチなどの詳細が含まれます。

明らかに、Google、Amazon、Microsoft、AMD、Intelの競争圧力に抑えられ、NVIDIAは夜通しで加速しました。B100和「X100」の研究開発。

B100:上場時期はすべてよりも高い

内部情報によれば、NVIDIAのB100は2024年第3四半期に量産され、一部の早期サンプルは2024年第2四半期に出荷される予定です。

性能とTCOの観点から、AmazonのTrainium2、GoogleのTPUv5、AMDのMI300X、IntelのGaudi 3またはMicrosoftのAthenaは、それに比べて弱い。

設計提携先やAMDまたはTSMCから得られる助成金を考慮しても、それらに勝つことはできません。

B100を市場に早く投入するため、NVIDIAは多くの妥協をした。

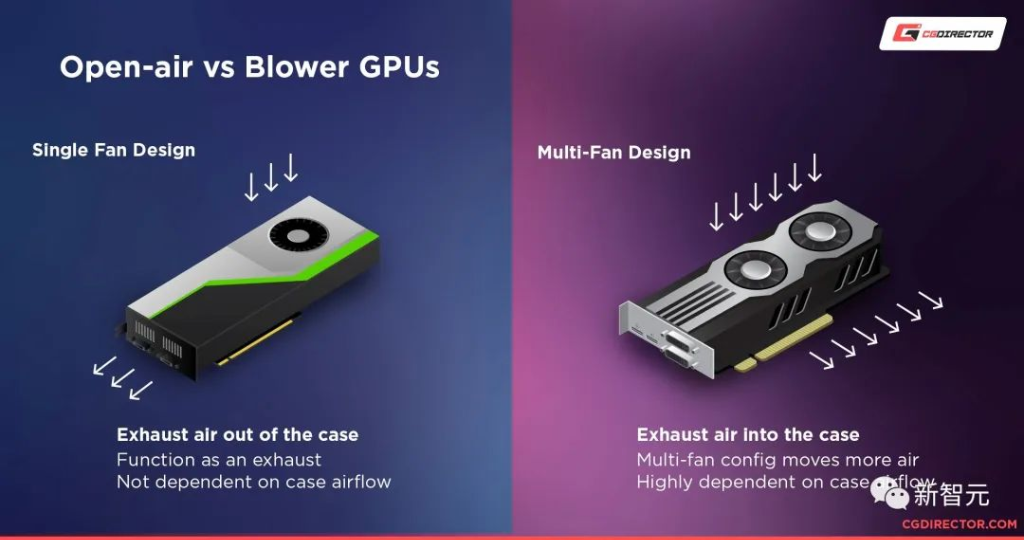

例えば、NVIDIAは本来より高い消費電力(1000W)を持つことを望んでいたが、最終的にはH100の700Wを引き続き使用することを選択した。

このようにして、B100が発売されたときには、引き続き風冷技術を使用することができます。

また、B100シリーズの初期にも、NVIDIAはPCIe5.0を使用し続けます。

5.0と700Wの組み合わせは、既存のH100 HGXサーバーに直接挿入することができ、サプライチェーン能力を大幅に向上させ、より早く量産・出荷することができるようになります。

5.0を使用し続ける決定をした理由の一部は、AMDとインテルがPCIe6.0の統合でまだ大きな遅れをとっていることです。そして、NVIDIA自身の内部チームですら、PCIe6.0CPUの使用準備ができていません。

また、彼らはより速いC2Cスタイルのリンクを使用する予定です。

将来的には、ConnectX-8にはPCIe6.0スイッチが統合されますが、現時点では誰も準備ができていません。

博通とAsteraLabsは、年末までにPCIe6.0リタイムクロッカーの量産に備えることができるようになると報じられています。これらの基板のサイズを考慮すると、必要なリタイムクロッカーの数はさらに増えるでしょう。

これは、最初のB100が3.2Tに制限され、ConnectX-7を使用した場合の速度が400Gであり、NVIDIAがPPTで宣言したGPUごとの800Gではないことを意味します。

電源、PCIe、ネットワーク速度を維持しつつ、空気を冷却することに成功した場合、製造も展開も容易になるでしょう。

英伟达は間もなく、水冷が必要な1,000W+のB100のバージョンを発売する予定です。

このバージョンB100では、ConnectX-8を使用して、各GPUに完全な800Gのネットワーク接続が提供されます。

イーサネット/InfiniBandに関して、これらのSerDesはまだ8x100Gです。

各GPUのネットワークスピードは倍増しましたが、彼らは依然として同じ51.2Tスイッチを通過する必要があるため、基数は半分に減少しました。一方、102.4TスイッチはB100世代ではもう使用されなくなります。

面白いことに、内部告発によると、B100のNVLinkコンポーネントは224G SerDesを採用すると言われています。もしこれが本当なら、NVIDIAは大きな進歩を遂げることになります。

ほとんどの業界関係者は、224Gが信頼できないと考えています。2024年にそれを実現することはできませんが、英伟達社の人々は除きます。

谷歌、Meta、またはAmazonのAIアクセラレーター224Gの生産目標は、2026/2027年に定められています。

もしNVIDIAが2024年/2025年にこれを実現した場合、彼らは手ごわい競合他社を負かすことが確実です。

報道によると、B100は引き続きTSMCのN4Pであり、3nmプロセスに基づく技術ではありません。

明らかに、このように大きいチップサイズに対して、台湾積体電路製造の3nmプロセスは未熟です。

英ウェイダの基板サプライヤーであるIbidenによると、基板サイズによると、英伟达は2つのシングルチップMCMで構成される設計を採用し、8または12のHBMスタックを含むようになったようです。

SambaNovaとインテルの来年のチップは、類似したマクロ設計を採用しています。

AMDのように混合接合技術を採用しなかったのは、NVIDIAが量産を必要としていたためであり、コストが彼らの大きな懸念事項だったからです。

SemiAnalysisによると、これら2つのB100チップのメモリ容量はAMDのMI300Xに近かったり、それ以上で、24GBのスタックに達すると予想されています。

風冷式のB100の速度は6.4Gbpsに達し、液冷式は最大で9.2Gbpsになる可能性があります。

また、NVIDIAはGB200とB40をロードマップに示しました。

GB200とGX200は両方ともGを使用していますが、これは明らかにプレースホルダーであり、NVIDIAはArmアーキテクチャをベースにした新しいCPUを発売します。Graceを長期間使用するつもりはありません。

B40はおそらくB100の半分で、1つのシングルN4Pチップと最大4または6層のHBMのみを持っています。L40Sとは異なり、これは小さなモデルの推論にとって意味があることです。

「X100」:致命一撃

公開されたロードマップで最も注目されたのは、NVIDIAの「X100」のスケジュールです。

興味深いことに、それは現在のAMDのMI400タイムテーブルと完全に一致しています。H100の発売から1年後、AMDはMI300X戦略を発表しました。

AMDがMI300Xに与えたパッケージングは印象的であり、彼らはより多くの計算機能とメモリを詰め込み、1年前のH100を超えることを望んでおり、ハードウェアのみでNVIDIAを超えることを目指しています。

NVIDIAも気付いています。競合他社に市場を奪われる良いチャンスを与える新しいGPUを2年ごとに発表しています。

追いつめられたNVIDIAは、製品サイクルを1年に加速し、競合他社に機会を与えません。たとえば、彼らは2025年に「X100」を発売し、B100より1年遅れる予定です。

当然、「X100」は現在まで量産されていない(B100とは異なります)。したがって、すべては未確定のままです。

過去には、NVIDIAは製品の次の世代に関する議論をしなかったことを知っておく必要があります。 今回は前例のないことです。

そして、名前はおそらく「X100」ではありません。

NVIDIAの伝統は、Ada Lovelace、Grace Hopper、Elizabeth Blackwellなどの優れた女性科学者の名前にちなんでGPUの名前を付けることです。

「X」と言えば、半導体と金属帯構造の研究者である謝希德が唯一論理的だが、彼女の身分を考慮すれば、その可能性は低いだろう。

サプライチェーンマスター:老黄の大勝負

英ウェイダが設立された当初、黄仁勲は供給チェーンの把握を積極的に推進し、巨大な成長目標を支援してきました。

彼らはキャンセル不可能な111.5億ドル相当の購買、生産能力、在庫コミットメントを引き受けるだけでなく、38.1億ドル相当の前払い契約にも同意しています。

言えることは、このサプライヤーに匹敵するものはない。

そして、NVIDIAの業績は一度ではありませんでした。彼らは供給不足時に創造的に供給量を増やすことができます。

2007年、黄仁勲と張忠謀の対話

1997年、私が張忠謀氏に会ったとき、100人しかいなかったNVIDIAは、その年に2,700万ドルの収益を達成しました。信じられないかもしれませんが、張忠謀氏は以前よく電話販売をし、訪問販売も行っていました。私はNVIDIAが何をやっているのか、私たちのチップのサイズがどれだけ必要であり、毎年大きくなっていくことを、張忠謀氏に説明していました。その後、NVIDIAは累計1.27億個のウエハを製造しました。その頃から、NVIDIAの年間成長率は100%に近づき、現在まで継続しています。つまり、過去10年間の複合年間成長率は約70%に達しました。当時、張忠謀は、NVIDIAがそんなに多くのウエハーを必要とする必要性を信じられなかったが、黄仁勲はやり遂げた。

Nvidiaは、供給に関する大胆な試みにより、巨大な成功を収めています。数十億ドルの在庫価値を定期的に減価する必要はありますが、彼らは依然として過剰な注文から正当な収益を得ています。

今回、NVIDIAはGPUの上流部品の大部分の供給を直接奪い取りました。

彼らはSK Hynix、Samsung、Micronの3つのHBMサプライヤーに非常に大きな注文をし、BroadcomとGoogle以外のすべての人々の供給を圧迫しました。同時に、彼らはTSMCのCoWoSのほとんどの供給とAmkorの能力も購入しました。

また、NVIDIAは、HGXカードやサーバーに必要な下流のコンポーネント、タイマー、DSP、光学デバイスなどを十分に活用しています。

もしサプライヤーがNVIDIAに要求を置いても無視する場合、彼らは古い「ニンジンとスティック」の対象になるでしょう。

一方面、彼らはNVIDIAから想像を絶する注文を受けるかもしれません。別の一方で、NVIDIAによって既存の供給チェーンから除外される可能性があります。

もちろん、NVIDIAは重要なサプライヤーであり、代替のできない単一供給源の場合にのみ、確約注文及び不可撤回の注文を使用します。

各サプライヤーは自分自身をAIの勝者だと考えているかのようです。部分的な理由は、NVIDIAがすべてのサプライヤーに多くの注文を出したことです。そして、彼らは自分たちが大部分のビジネスを勝ち取ったと思っています。しかし、実際には、NVIDIAの成長速度が速すぎるだけです。

市場動向に戻ると、NVIDIAの目標は来年に700億ドルを超えるデータセンターの売り上げを達成することですが、上流には100万台以上の機器を持つGoogleが十分な生産能力を持っています。AMDのAI領域における総生産能力は非常に限られており、最高でも数十万台に過ぎません。

ビジネス戦略:潜在的な反競争

皆さんご存知のように、NVIDIAは大きなGPU需要を利用して、顧客に製品を販売しています。

サプライチェーンには多数の情報が漏れており、NVIDIAは一連の要因に基づいて特定の企業に優先的な割り当てを提供します。これには、多様な調達計画、AIチップの独自開発計画、NVIDIAのDGX、NIC、スイッチ、および/または光学装置の購入などが含まれます。

実際に、NVIDIAのバンドル販売は非常に成功しています。それまでには、小規模なファイバー光送受信機サプライヤーに過ぎませんでしたが、彼らのビジネスは1四半期で2倍に拡大し、来年の出荷量は10億ドルを超える見込みです-自社のGPUまたはネットワークチップビジネスの成長速度を大きく超えています。

これらの戦略はかなり綿密と言えます。

例えば、NVIDIAのシステムで3.2Tネットワークと信頼性の高いRDMA / RoCEを実現するには、NVIDIAのNICを使用することが唯一の方法です。もちろん、一方では、インテル、AMD、およびBroadcomの製品が競争力に欠けていることも原因です-これらの製品はまだ200Gのレベルにとどまっています。

そして、サプライチェーンの管理により、NVIDIAは400G InfiniBand NICの納期を400G Ethernet NICよりも短縮することができました。これら2つのNIC(ConnectX-7)は、実際にはチップと回路基板の設計が完全に同じです。

原因は、NVIDIAのSKU構成にあり、実際のサプライチェーンのボトルネックではありません--より高コストなInfiniBandスイッチを購入することを余儀なくされ、標準のEthernetスイッチを購入することができませんでした。

これだけではなく、L40およびL40S GPUに対するサプライチェーンの魅力を見ると、NVIDIAがまた物流に手を加えていることがわかります- より多くのH100の配分を獲得するため、OEMメーカーはL40Sをより多く購入する必要があります。

これは、NVIDIAのPC分野での取り組みと同様であり、ノートブックメーカーとAIBパートナーは、より希少かつ高利益なG102/G104(ハイエンドおよびフラグシップGPU)を得るために、より多くのG106/G107(ミドル/ローエンドGPU)を購入する必要があります。

配合として、サプライチェーンの人々には、L40Sの方がA100よりも優れているという理由が指摘されました。理由は、より高いFLOPSを持っているからです。

しかし、実際には、これらのGPUはLLM推論に適していないことがあります。なぜなら、彼らのメモリバンド幅はA100の半分以下ですし、NVLinkもありません。

これは、L40SでLLMを実行し、TCOを良好にすることは、非常に小さなモデルでない限りほぼ不可能であることを意味し、大量の処理は、ユーザーごとに割り当てられたトークン/ sがほとんど使用できなくなるため、理論上のFLOPSは実際のアプリケーションでは無意味になります。

また、NVIDIAのMGXモジュール化プラットフォームは、サーバー設計の困難な作業を省略するものの、OEMの利益率を低下させてしまいました。

デル、HP、レノボなどの企業は明らかにMGXに対して抵抗的な態度を取っていますが、AMD、広達、ASUS、ギガバイトなどの企業はこの空白を埋めるために競って、低コストの「企業向け人工知能」を商品化しています。

そして、L40SおよびMGXの取引に参加しているOEM/ODMは、NVIDIAからより良いメインGPU製品の割り当てを受けることができます。

光電共封装 (Co-Packaged Optics)

CPOに関しては、NVIDIAも重視しています。

彼らはAyar Labsからの解決策や、Global FoundriesとTSMCから自分たちで得た解決策を含む、さまざまな解決策を研究しています。

現在、NVIDIAはいくつかの新興企業のCPOプログラムを調査していますが、まだ最終的な決定を下していません。

分析によると、NVIDIAはX100のNVSwitchにCPOを統合する可能性が非常に高いとされています。

GPU本体に直接統合することはコストが高すぎる可能性があり、信頼性の面でも困難です。

光回線交換機(Optical Circuit Switch)

Googleの人工知能インフラストラクチャにおける最大の利点の1つは、光ファイバー交換機です。

明らかに、NVIDIAも同様の取り組みをしています。現在、彼らは多くの企業と接触し、共同開発を望んでいます。

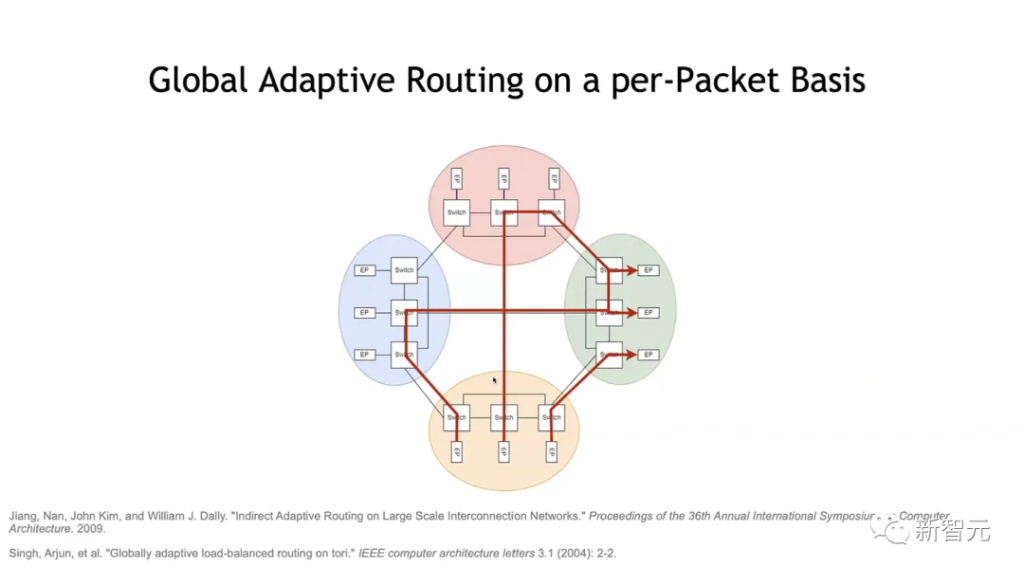

NVIDIAはFat Treeが既に拡張の限界に達していることに気付き、別のトポロジー構造が必要であると認識している。

グーグルが6Dトーラスを選択したのとは異なり、NVIDIAはドラゴンフライ構造を採用する傾向にあります。

英伟达はまだOCSの出荷から遠く離れていますが、2025年までにはこの目標に近づけるように願っていますが、おそらく実現できないでしょう。

OCS + CPOは聖杯であり、特にデータパケットによる交換が可能になった場合、ゲームルールを直接変更することができます。

しかしながら、この能力を展示した人はまだいません。Googleですらその能力を持っていません。

英伟达のOCSとCPOはまだ研究部門に2つのPPTしかありませんが、アナリストはCPOが2025年から2026年にかけて製品化される可能性が高いと考えています。

本文の出典:新智元、原題:「NVIDIA 25年のロードマップが流出!ホンコンがAMDを打ち負かすための秘密兵器 X100 も明らかに」

当然,英伟达也不会坐以待毙。

当然,英伟达也不会坐以待毙。