迄今最も強力なオープンソースLlama 3モデルを2週間以内に見ることができるかもしれません。

アメリカ東海岸時間7月12日金曜日、メディアは従業員の情報源を引用して、Metaが7月23日に第3世代の大規模言語モデル(LLM)Llama 3をリリースする計画だと報じました。この最新版モデルは、4050億のパラメータを持ち、マルチモーダルモデルでもあるため、画像とテキストを理解して生成することができます。この最も強力なバージョンがオープンソースかどうかは明らかにされていません。$メタ プラットフォームズ A (META.US)$メタ社は上記情報に関してコメントを拒否しました。Metaは金曜日に2.7%下落しました。

メタ社は上記のニュースについてコメントを拒否しました。Metaは金曜日に2.7%下落しました。

去年7月、MetaがリリースしたLlama 2には3つのバージョンがあり、最大バージョンの70Bのパラメータースケールは700億です。今年4月、MetaはLlama 3Metaをリリースし、これを「迄今までに最も強力なオープンソースLLM」と呼んでいます。当時、リリースされたLlama 3には8Bと70Bの2つのバージョンがありました。

MetaのCEO、ザッカーバーグ氏は、大規模なLlama 3のバージョンには4000億を超えるパラメーターがあると述べました。Metaは、4000億のパラメータースケールを持つLlama 3をオープンソースにするかどうかは明らかにしていませんが、その時点でトレーニングを受けています。

Llama 3は、前世代と比較すると質的飛躍を遂げました。 Llama 2は20兆個のトークンを使用してトレーニングされましたが、Llama 3の大規模バージョンのトークンは15兆を超えます。

Metaは、事前トレーニングとトレーニング後の改善により、事前トレーニングと指示の調整によるモデルが現在の8Bと70Bの2つのパラメータースケールの最高のモデルであると述べています。トレーニング後にプログラムが改善された場合、モデルの誤り拒否率(FRR)が大幅に低下し、一貫性が向上し、モデルが反応する多様性が増加します。推論、コード生成、および指令トレースの機能において、Llama 3はLlama 2に比べて非常に改善され、操作が容易になります。

4月にMetaが発表したところによると、8Bおよび70BバージョンのLlama 3指示調整モデルは、大規模マルチタスク言語理解データセット(MMLU)、大学院レベルの専門家推論(GPQA)、数学評価セット(GSM8K)、およびプログラミング多言語テスト(HumanEval)において、Mistral、GoogleのGemmaおよびGemini、およびAnthropicのClaude 3よりも高い評価を獲得しています。8Bおよび70Bバージョンの事前トレーニングLlama 3は、Mistral、Gemma、Gemini、およびMixtralよりも優れたパフォーマンス評価を獲得しています。

当時のソーシャルメディアのユーザーは、基準テストによると、現行のLlama 3モデルが完全にGPT-4レベルではないとコメントしましたが、まだ導入前の大きなサイズのモデルはGPT-4レベルに達すると信じられています。

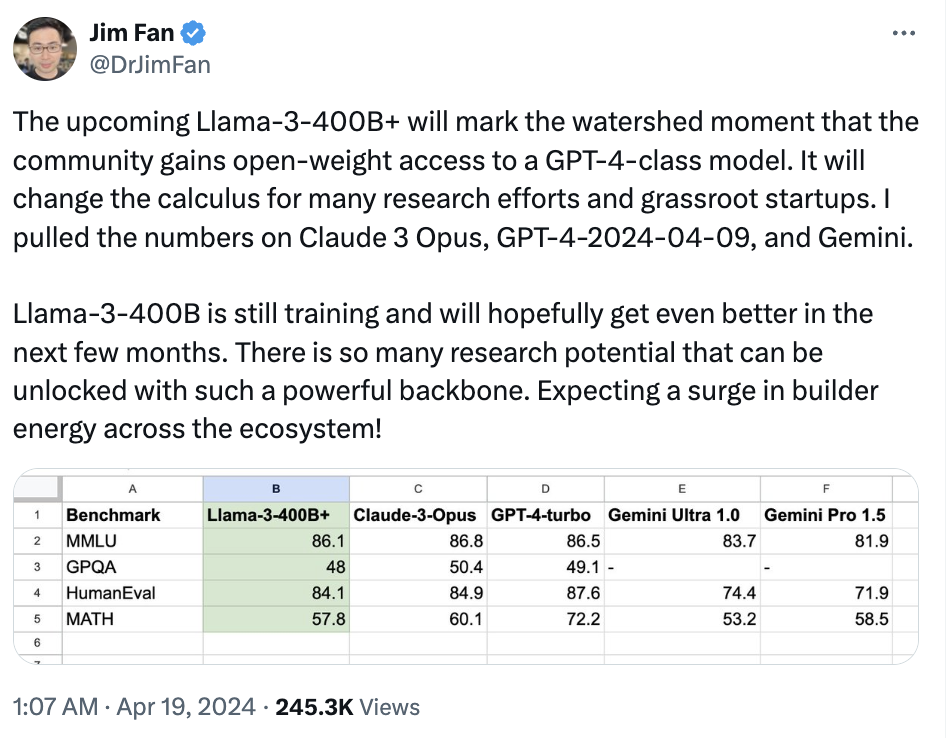

英伟达のシニアサイエンティスト、Jim Fan氏は、Llama 3の発表が技術的進歩から脱却し、オープンソースモデルとトップクラスのクローズドモデルが肩を並べる象徴となっていると考えています。

Jim Fan氏が共有したベンチマークテストによれば、Llama 3 400Bは実質的にClaude“Big Cup”および新しいバージョンのGPT-4 Turboに匹敵し、分水嶺となるでしょう。Llama 3のリリースは、大きな研究潜在能力を解放し、生態系全体の発展を促進し、オープンソースコミュニティがGPT-4レベルのモデルを利用できるようになると信じられています。

その後、研究者はLlama 3を微調整することを決定しておらず、Llama 3がマルチモーダルモデルであるかどうかもまだ決定していません。正式版のLlama 3は、今年7月に正式に発表される予定です。

オープンAIなどの開発者とは異なり、MetaはLLMをオープンソースにすることを目指していますが、この競争はますます激しくなっています。 Google、Tesla CEO MuskのxAI、Mistralなどの競合他社も無料のAIモデルをリリースしています。

Llama 3の発表後、同じ4月に現れた4800億のパラメーターモデルArcticはLlama 3、Mixtraを破り、世界最大のオープンソースモデルの記録を更新しました。

Arcticは、完全に新しいDense-MoEアーキテクチャに基づいて設計されており、10Bの密なトランスフォーマーモデルと128×3.66BのMoE MLPで構成されています。15兆個のトークンでトレーニングされました。 Llama 3 8BおよびLlama 2 70Bに比べ、Arcticが使用したトレーニング計算リソースは半分以下であり、評価指標は相当なスコアを獲得しています。

編集/Jeffrey