①Cerebrasは独自のチップ計算システムに基づいて、世界最速のAI推論サービスを提供しました。②Cerebrasは巨大なチップに直接メモリを組み込むことで、大規模なオンチップメモリと非常に高いメモリ帯域幅を持っています。

《科創板日報》8月28日、エディター 朱凌による報道。米国時間水曜日の市場後、英伟达がセカンダリマーケット全体の重要な四半期報告書を公表し、世界中の投資家は非常に緊張しています。前日(米国時間8月27日)、AIプロセッサチップのユニコーンCerebras Systemsは、独自のチップ計算システムに基づいて、世界最速のAI推論サービスを提供し、英伟达H100 GPUを使用したシステムよりも10〜20倍高速であると主張しています。

現在、英伟达GPUはAIトレーニングと推論の両方で市場をリードしています。Cerebrasは2019年に最初のAIチップをリリース以来、AIチップと計算システムの販売に特化し、AIトレーニングの領域で英伟达に挑戦してきました。

米国のテクノロジーメディアThe Informationによると、AI推論サービスのおかげで、OpenAIの今年の収益は34億ドルに達すると予想されています。AI推論市場が非常に大きいため、Cerebrasの共同創設者兼CEOであるアンドリュー・フェルドマンは、CerebrasもAI市場で一定の地位を確保すると述べています。

米国のテクノロジーメディアThe Informationによると、AI推論サービスのおかげで、OpenAIの今年の収益は34億ドルに達すると予想されています。AI推論市場が非常に大きいため、Cerebrasの共同創設者兼CEOであるアンドリュー・フェルドマンは、CerebrasもAI市場で一定の地位を確保すると述べています。

CerebrasのAI推論サービスの導入は、AIチップおよび計算システム以外の、使用量ベースの第2の収益曲線を開始し、英伟达に対する包括的な攻撃を開始しました。「英伟达から十分に市場シェアを奪いました。」とフェルドマンは述べています。

速くて安い

CerebrasのAI推論サービスは、速度とコストの両面で著しい優位性を発揮しています。フェルドマンによると、1秒あたりに出力できるトークン数で見ると、CerebrasのAI推論速度は、マイクロソフトAzure、アマゾンドットコムなどのクラウドコンピューティングサービスが実行中のAI推論サービスの20倍です。

フェルドマンは記者会見で、同時にCerebrasとアマゾンドットコムのAI推論サービスの起動を行いました。Cerebrasは瞬時に推論作業を完了し、出力、処理速度は1秒あたり1832のトークンに達し、アマゾンドットコムは数秒かかって出力を完了し、処理速度は1秒あたり93のトークンです。

フェルドマンは、より高速な推論速度は、リアルタイムのインタラクティブな音声回答を実現したり、複数の結果や外部情報源、長い文書を呼び出すことで、より正確で関連性の高い回答を得ることができることを意味し、AI推論に質的な飛躍をもたらします。

速度の優位性に加えて、Cerebrasには大幅なコストの利点もあります。フェルドマンは、CerebrasのAI推論サービスのコストパフォーマンスはAWSなどの100倍だと述べています。例えば、MetaのLlama 3.1 70Bオープンソースの大規模言語モデルを実行する場合、このサービスの価格はトークン当たりわずか60セントであり、一般的なクラウドサービスプロバイダーが提供する同じサービスのトークン価格は2.90ドルです。

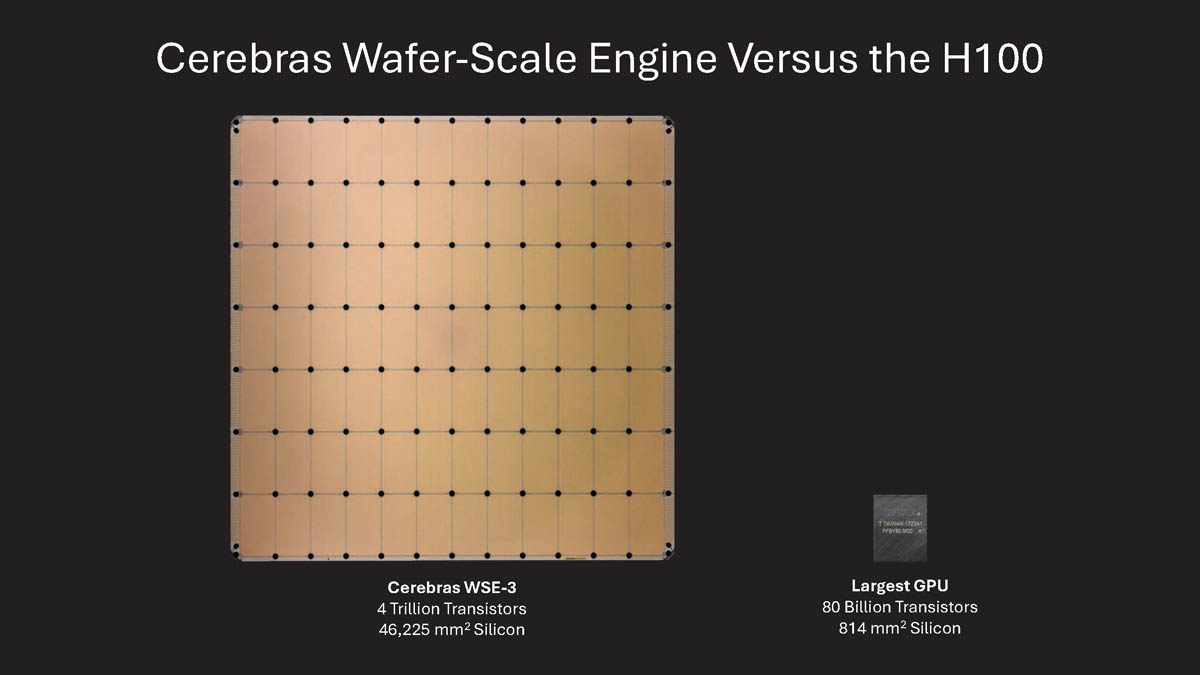

現在の最大のGPU面積の56倍です。

CerebrasのAI推論サービスが高速でコスト効果が良い理由は、WSE-3チップの設計にあります。これはCerebrasが今年3月に発売した第3世代のプロセッサチップで、非常に大きなサイズであり、ほぼ12インチの半導体チップの表面全体に相当するか、あるいは本よりも大きく、単体の面積は約462.25平方センチメートルになります。これは現在の最大のGPU面積の56倍です。

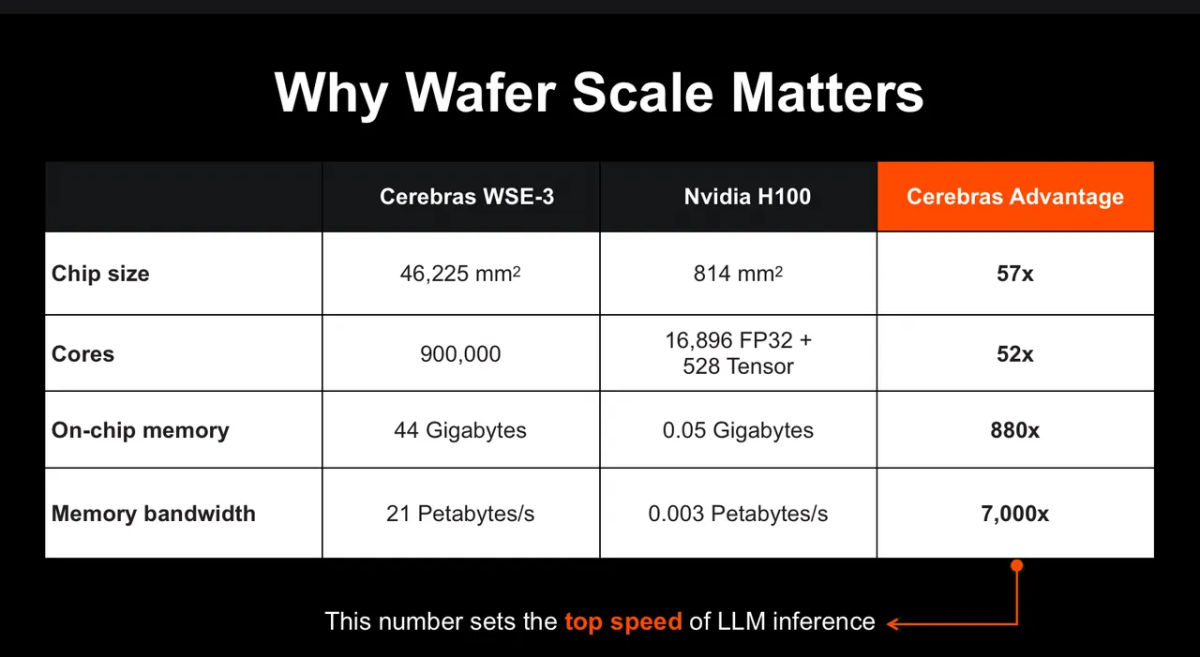

WSE-3チップは、NVIDIAのようにインターフェース接続を介してアクセスする必要がある独立した高帯域幅のメモリ(HBM)を使用していません。代わりに、メモリを直接チップに内蔵しています。

チップのサイズのおかげで、WSE-3のチップ上メモリ(On-chip memory)は44Gに達し、NVIDIA H100の900倍であり、メモリ帯域幅はNVIDIA H100の7000倍です。

フェルドマンは、言語モデルの推論性能を制限するメモリ帯域幅が根本的な要素であると述べた。Cerebrasは論理とメモリを1つの巨大なチップに統合し、大容量のオンチップメモリと非常に高いメモリ帯域幅を持ち、データを迅速に処理して推論結果を生成できます。GPUでは到達できない速度です。

速度とコストの利点に加えて、WSE-3チップはAIのトレーニングと推論の両方に優れた性能を持っています。さまざまなAIタスクを処理する際に優れた性能を発揮します。

計画によると、Cerebrasは複数の場所にAI推論のためのデータセンターを設立し、推論能力に基づいて料金を請求します。同時に、CerebrasはWSE-3ベースのCS-3コンピューティングシステムをクラウドサービスプロバイダーに販売する試みも行います。

根据美国科技媒体The Information的报道,得益于AI推理服务,OpenAI今年收入预计将达到34亿美元。既然AI推理的蛋糕这么大,Cerebras联合创始人兼首席执行官安德鲁·费尔德曼表示,Cerebras也要在AI市场上占据一席之地。

根据美国科技媒体The Information的报道,得益于AI推理服务,OpenAI今年收入预计将达到34亿美元。既然AI推理的蛋糕这么大,Cerebras联合创始人兼首席执行官安德鲁·费尔德曼表示,Cerebras也要在AI市场上占据一席之地。